Appearance

快速接入

各模型域名替换规则

| 模型供应商 | 原域名 | 替换为 | 备注 |

|---|---|---|---|

| OpenAI | https://api.openai.com/v1 | https://api.openai-proxy.org/v1 | 一般需要加/v1 |

| Anthropic | https://api.anthropic.com | https://api.openai-proxy.org/anthropic | 添加/anthropic后缀 |

| Gemini | https://generativelanguage.googleapis.com | https://api.openai-proxy.org/google | 添加/google后缀 |

协议选择

API兼容性

大部分代理仅支持ChatCompletion协议,而CloseAI作为业界最专业的中转平台,全面支持所有主流的协议及协议间转换,包括:

- 支持OpenAI ChatCompletion兼容协议调用所有聊天模型,自动转换为其他协议

- 支持OpenAI Response协议

- 支持Anthropic Claude原生协议

- 支持Google Gemini原生协议

- 支持Google Vertex原生协议

不同协议对应不同的官方SDK,一般来说,应该尽可能优先使用原生协议访问模型,性能最好,能发挥原生协议最大的效果(比如返回通过缓存节省成本、展示思维链、控制思考深度等)。

但是有些场景可能就是希望通过OpenAI的SDK去使用所有模型,比如Cursor中或者写代码方便,因此CloseAI也支持通过OpenAI协议访问所有模型。

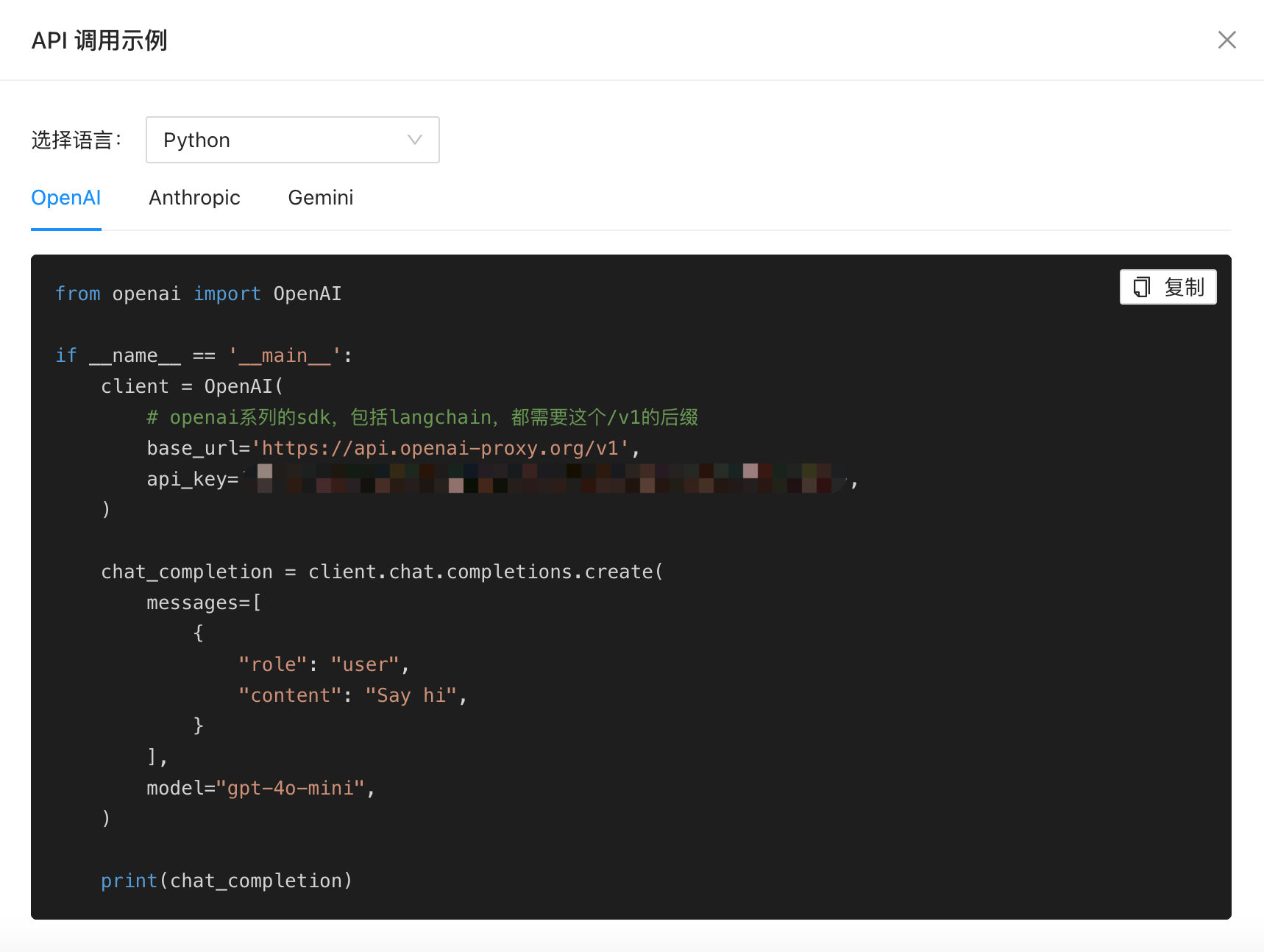

示例

以claude-sonnet-4-20250514为例,可以通过2种方式访问

1. OpenAI兼容协议访问

python

from openai import OpenAI

if __name__ == '__main__':

client = OpenAI(

# openai系列的sdk,包括langchain,都需要这个/v1的后缀

base_url='https://api.openai-proxy.org/v1',

api_key='sk-xxxxxx',

)

chat_completion = client.chat.completions.create(

messages=[

{

"role": "user",

"content": "Say hi",

}

],

model="claude-sonnet-4-20250514", # 如果是其他兼容模型,比如deepseek,直接这里改模型名即可,其他都不用动

)

print(chat_completion)2. Claude原生协议访问

python

from anthropic import Anthropic

if __name__ == '__main__':

client = Anthropic(

base_url='https://api.openai-proxy.org/anthropic',

api_key='sk-xxxx',

)

message = client.messages.create(

max_tokens=1024,

messages=[

{

"role": "user",

"content": "Hello, Claude",

}

],

model="claude-sonnet-4-20250514",

)

print(message.content)原生协议访问,可以获得比兼容协议更多的控制性,比如:

- 精确控制缓存使用,命中缓存后节省90%的成本,同时可以获得更高的TPM吞吐量,OpenAI兼容协议一般无法用到缓存,导致成本较贵。

- 展示思维链,并在连续调用中保持思维一致性,OpenAI兼容协议无法做到。

- 精确控制是否开启思考和对应思考深度,OpenAI兼容协议只能粗略的定义

high或者low。 - 可以调用原生工具和beta特性,比如

computer-use等。

常见问题

注意一定要替换为我们的api base和api key,差一个都是不对的。

WARNING

注意配置openai api_base时,应该加上一个/v1的后缀,而不是只有域名,要不然会报404错误。

其他代码示例

TIP

秘钥管理 页面可以动态获取您的代码示例,请至秘钥管理页面API示例中查看,支持python/curl